Zosia KleinmanRedaktor technologii

Zosia KleinmanRedaktor technologii BBC

BBCMówi się, że Mark Zuckerberg rozpoczął pracę na ranczu Koolau, swojej rozległej posiadłości o powierzchni 1400 akrów na hawajskiej wyspie Kauai, już w 2014 roku.

Ma się tam znaleźć schronisko z własnym zapasem energii i żywności, choć według raportu magazynu Wired stolarze i elektrycy pracujący na miejscu nie mogą o nim rozmawiać na mocy umów o zachowaniu poufności.

Wysoki na sześć stóp mur zasłaniał projekt przed pobliską drogą.

Zapytany w zeszłym roku, czy tworzy bunkier na dzień zagłady, założyciel Facebooka odpowiedział kategorycznie „nie”. Podziemna przestrzeń o powierzchni około 5000 stóp kwadratowych, wyjaśnił, „przypomina małe schronienie, przypomina piwnicę”.

Nie powstrzymało to spekulacji – podobnie jak w przypadku jego decyzji o zakupie 11 nieruchomości w dzielnicy Crescent Park w Palo Alto w Kalifornii, najwyraźniej dodając pod nimi powierzchnię podziemną o powierzchni 7000 stóp kwadratowych.

Bloomberga za pośrednictwem Getty Images

Bloomberga za pośrednictwem Getty ImagesChoć jego pozwolenia na budowę dotyczą piwnic, według „New York Timesa” niektórzy z jego sąsiadów nazywają je bunkrem. Albo jaskinia nietoperzy miliardera.

Następnie pojawiają się spekulacje na temat innych liderów technologii, z których niektórzy wydają się być zajęci wykupem kawałków ziemi z podziemnymi przestrzeniami, gotowymi do przekształcenia w luksusowe bunkry warte wiele milionów funtów.

Reid Hoffman, współzałożyciel LinkedIn, mówił o „ubezpieczeniu na wypadek apokalipsy”. To mniej więcej połowa superbogatych, jak twierdził wcześniej, a Nowa Zelandia jest popularnym kierunkiem dla domów.

Czy zatem naprawdę mogli przygotowywać się do wojny, skutków zmian klimatycznych lub innego katastrofalnego wydarzenia, o którym reszta z nas jeszcze nie wiedziała?

Wiadomości z Getty Images

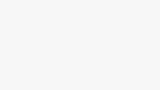

Wiadomości z Getty ImagesW ciągu ostatnich kilku lat rozwój sztucznej inteligencji (AI) tylko dodał do listy potencjalnych problemów egzystencjalnych. Wiele osób jest głęboko zaniepokojonych samą szybkością postępu.

Według doniesień jednym z nich jest Ilya Sutskever, główny naukowiec i współzałożyciel Open AI.

Do połowy 2023 r. firma z San Francisco wypuściła ChatGPT – chatbota, z którego korzystają obecnie setki milionów ludzi na całym świecie – i szybko pracowała nad aktualizacjami.

Jednak tego lata Sutskever był coraz bardziej przekonany, że informatycy są o krok od opracowania sztucznej inteligencji ogólnej (AGI) – punktu, w którym maszyny dorównują inteligencji ludzkiej – jak wynika z książki dziennikarki Karen Hao.

Podczas spotkania Sutskever zasugerował swoim współpracownikom, że powinni wykopać podziemny schron dla najlepszych naukowców firmy, zanim tak potężna technologia zostanie udostępniona światu, relacjonuje Hao.

AFP za pośrednictwem Getty Images

AFP za pośrednictwem Getty Images„Zdecydowanie zbudujemy bunkier, zanim wypuścimy AGI” – podobno powiedział, choć nie jest jasne, kogo miał na myśli, mówiąc „my”.

Rzuca światło na dziwny fakt: wielu czołowych informatyków i liderów technologicznych, z których część ciężko pracuje nad opracowaniem niezwykle inteligentnej formy sztucznej inteligencji, również wydaje się głęboko boi tego, co może pewnego dnia zrobić.

Kiedy więc dokładnie – jeśli w ogóle – pojawi się AGI? I czy naprawdę mogłoby to okazać się na tyle transformacyjne, że zwykli ludzie się bali?

Przybycie „wcześniej niż myślimy”

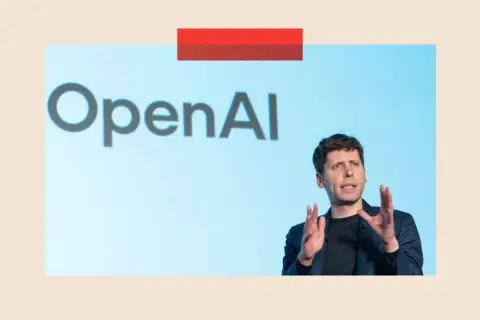

Liderzy technologii twierdzą, że AGI jest nieuchronne. Szef OpenAI Sam Altman powiedział w grudniu 2024 r., że nastąpi to „wcześniej, niż większość ludzi na świecie myśli”.

Sir Demis Hassabis, współzałożyciel DeepMind, przewidział, że w ciągu najbliższych pięciu do dziesięciu lat, natomiast założyciel Anthropic, Dario Amodei, napisał w zeszłym roku, że jego preferowany termin – „potężna sztuczna inteligencja” – może pojawić się już w 2026 roku.

Inne są wątpliwe. „Cały czas przesuwają słupki bramki” – mówi Dame Wendy Hall, profesor informatyki na Uniwersytecie w Southampton. – To zależy, z kim rozmawiasz. Rozmawiamy przez telefon, ale prawie słyszę przewracanie oczami.

„Społeczność naukowa twierdzi, że technologia sztucznej inteligencji jest niesamowita” – dodaje – „ale daleko jej do inteligencji ludzkiej”.

Najpierw musiałoby nastąpić szereg „fundamentalnych przełomów”, zgadza się Babak Hodjat, dyrektor ds. technologii w firmie technologicznej Cognizant.

Co więcej, jest mało prawdopodobne, że nastąpi to w jednej chwili. Sztuczna inteligencja jest raczej szybko rozwijającą się technologią, jest w drodze i wiele firm na całym świecie ściga się, aby opracować jej własne wersje.

Ale jednym z powodów, dla których pomysł ten ekscytuje niektórych w Dolinie Krzemowej, jest to, że uważa się go za prekursora czegoś jeszcze bardziej zaawansowanego: ASI, czyli sztucznej superinteligencji – technologii, która przewyższa ludzką inteligencję.

Już w 1958 roku pojęcie „osobliwości” przypisano pośmiertnie urodzonemu na Węgrzech matematyk John von Neumann. Odnosi się do momentu, w którym inteligencja komputerowa wykracza poza ludzkie zrozumienie.

Obrazy Getty’ego

Obrazy Getty’egoNiedawno ukazała się książka Genesis z 2024 r., napisana przez Erica Schmidta, Craiga Mundy’ego i nieżyjącego już Henry’ego Kissingera, bada koncepcję superpotężnej technologii, która staje się tak skuteczna w podejmowaniu decyzji i przywództwie, że w rezultacie całkowicie przekazujemy jej kontrolę.

Kłócą się, a nie czy, to kwestia tego, kiedy.

Pieniądze dla wszystkich, bez konieczności pracy?

Zwolennicy AGI i ASI są niemal ewangeliczni co do korzyści, jakie z nich płyną. Argumentuje, że znajdzie nowe lekarstwa na śmiertelne choroby, rozwiąże problem zmian klimatycznych i wynajdzie niewyczerpane zasoby czystej energii.

Elon Musk stwierdził nawet, że superinteligentna sztuczna inteligencja może zapoczątkować erę „powszechnych wysokich dochodów”.

Niedawno poparł pomysł, że sztuczna inteligencja stanie się tak tania i powszechna, że praktycznie każdy będzie chciał mieć „własne, osobiste R2-D2 i C-3PO” (nawiązując do droidów z Gwiezdnych Wojen).

„Każdy będzie miał najlepszą opiekę medyczną, żywność, transport do domu i wszystko inne. Zrównoważona obfitość” – zachwycał się.

Oczywiście jest też przerażająca strona. Czy technologia może zostać przejęta przez terrorystów i wykorzystana jako potężna broń, czy też sama zdecyduje, że ludzkość jest przyczyną problemów świata i nas zniszczy?

AFP za pośrednictwem Getty Images

AFP za pośrednictwem Getty Images„Jeśli jest mądrzejszy od ciebie, musimy go powstrzymać” – ostrzegł Tim Berners Lee, twórca sieci WWW, w rozmowie z BBC na początku tego miesiąca.

„Musimy umieć to wyłączyć”.

Rządy podejmują pewne kroki ochronne. W Stanach Zjednoczonych, gdzie ma swoją siedzibę wiele wiodących firm zajmujących się sztuczną inteligencją, prezydent Biden wydał w 2023 r. zarządzenie wykonawcze, które nakładało na niektóre firmy obowiązek udostępniania rządowi federalnemu wyników testów bezpieczeństwa – choć od tego czasu prezydent Trump odwołał część zarządzenia, nazywając je „barierą” dla innowacji.

Tymczasem w Wielkiej Brytanii dwa lata temu utworzono AI Safety Institute – instytucję badawczą finansowaną przez rząd – aby lepiej zrozumieć zagrożenia stwarzane przez zaawansowaną sztuczną inteligencję.

Są też superbogaci, którzy mają własne plany ubezpieczenia na wypadek apokalipsy.

Obrazy Getty’ego

Obrazy Getty’ego„Mówienie, że «kupujesz dom w Nowej Zelandii», to trochę mrugnięcie okiem, mrugnięcie okiem, nic więcej nie mów” – powiedział wcześniej Reid Hoffman. To samo prawdopodobnie tyczy się bunkrów.

Ale jest tu wyraźnie ludzka wada.

Spotkałem kiedyś byłego ochroniarza pewnego miliardera z własnym „bunkierem”, który powiedział mi, że jeśli rzeczywiście do tego dojdzie, priorytetem jego zespołu ochrony będzie wyeliminowanie wspomnianego szefa i samodzielne dostanie się do bunkra. I nie wyglądał, jakby żartował.

Czy to wszystko alarmistyczne bzdury?

Neil Lawrence jest profesorem uczenia maszynowego na Uniwersytecie Cambridge. Dla niego cała ta debata sama w sobie jest bzdurą.

„Pojęcie sztucznej inteligencji ogólnej jest tak samo absurdalne, jak pojęcie «sztucznego pojazdu ogólnego»” – argumentuje.

„Właściwy pojazd zależy od kontekstu. Leciałem do Kenii Airbusem A350, codziennie dojeżdżam na uniwersytet samochodem, do stołówki chodzę pieszo… Nie ma pojazdu, który byłby w stanie to wszystko zrobić”.

Dla niego rozmowa o AGI jest odskocznią.

„Technologia, którą (już) zbudowaliśmy, po raz pierwszy pozwala normalnym ludziom bezpośrednio rozmawiać z maszyną i potencjalnie sprawić, by zrobiła to, co zamierza. To jest absolutnie niezwykłe… i całkowicie transformacyjne.

„Największym zmartwieniem jest to, że jesteśmy tak wciągnięci w narracje wielkich technologii na temat AGI, że brakuje nam sposobów, w jakie powinniśmy ulepszać życie ludzi”.

Obrazy Getty’ego

Obrazy Getty’egoObecne narzędzia sztucznej inteligencji są szkolone w oparciu o góry danych i dobrze wykrywają wzorce: oznaki nowotworu na skanach lub słowa, które najprawdopodobniej pojawią się po sobie w określonej kolejności. Ale nie „czują”, niezależnie od tego, jak przekonujące mogą wydawać się ich reakcje.

„Istnieją pewne„ oszukańcze ”sposoby, aby model wielkojęzykowy (podstawa chatbotów AI) zachowywał się tak, jakby miał pamięć i się uczył, ale są one niezadowalające i zupełnie gorsze od ludzi” – mówi Hodjat.

Vince Lynch, dyrektor generalny kalifornijskiej IV.AI, również obawia się przesadzonych deklaracji na temat AGI.

„To świetny marketing” – mówi. „Jeśli jesteś firmą, która buduje najmądrzejszą rzecz, jaka kiedykolwiek istniała, ludzie będą chcieli dać ci pieniądze”.

Dodaje: „To nie jest kwestia dwóch lat. Wymaga to tak wielu obliczeń, tyle ludzkiej kreatywności, tyle prób i błędów”.

Obrazy Getty’ego

Obrazy Getty’egoZapytany, czy wierzy, że AGI kiedykolwiek się zmaterializuje, następuje długa pauza.

– Naprawdę nie wiem.

Inteligencja bez świadomości

W pewnym sensie sztuczna inteligencja zdobyła już przewagę nad ludzkimi mózgami. Generacyjne narzędzie AI może w jednej chwili być ekspertem w historii średniowiecza, a w następnej rozwiązywać złożone równania matematyczne.

Niektóre firmy technologiczne twierdzą, że nie zawsze wiedzą, dlaczego ich produkty reagują w taki sposób. Meta twierdzi, że istnieją pewne oznaki poprawy jej systemów AI.

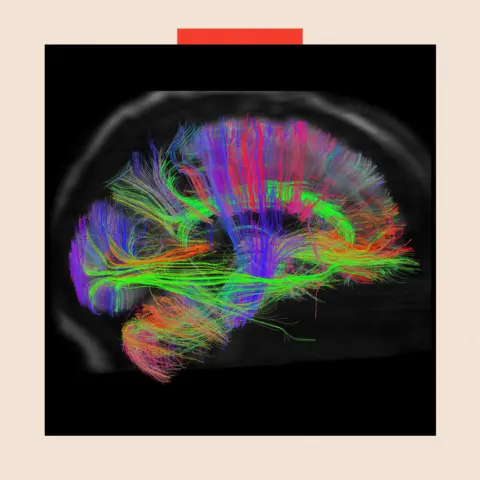

Ostatecznie jednak, niezależnie od tego, jak inteligentne staną się maszyny, biologicznie ludzki mózg nadal zwycięża. Ma około 86 miliardów neuronów i 600 bilionów synaps, o wiele więcej niż sztuczne odpowiedniki.

Mózg również nie musi robić przerw między interakcjami i stale dostosowuje się do nowych informacji.

„Jeśli powiesz człowiekowi, że na egzoplanecie odkryto życie, natychmiast się tego nauczy, co będzie miało wpływ na jego postrzeganie świata w przyszłości. W przypadku modelu LLM (Large Language Model) będzie to wiedział tylko wtedy, gdy będziesz mu to powtarzał jako fakt” – mówi Hodjat.

„LLM nie mają także metapoznania, co oznacza, że nie do końca wiedzą to, co wiedzą. Wydaje się, że ludzie mają zdolność do introspekcji, czasami nazywana świadomością, która pozwala im wiedzieć to, co wiedzą.”

Jest to fundamentalna część ludzkiej inteligencji, której nie udało się jeszcze odtworzyć w laboratorium.

Autorzy najważniejszych zdjęć: The Washington Post za pośrednictwem Getty Images/Getty Images MASTER. Zdjęcie główne przedstawia Marka Zuckerberga i zdjęcie bunkra w nieznanym miejscu

Głębokość BBC to strona internetowa i aplikacja, w której można uzyskać najlepsze analizy, ze świeżymi perspektywami, które podważają założenia i dogłębnymi raportami na temat najważniejszych bieżących problemów. Prezentujemy także skłaniające do myślenia treści z BBC Sounds i iPlayera. Możesz zapisać się na powiadomienia, które będą Cię informować o publikacji artykułu BBC InDepth – dowiedz się jak się tutaj zarejestrować.